Berkembangnya teknologi informasi telah membawa dampak besar pada berbagai aspek kehidupan, termasuk dalam hal pengumpulan dan analisis data. Dalam era digital ini, data menjadi salah satu aset yang paling berharga. Namun, jumlah data yang dihasilkan setiap harinya semakin besar dan kompleks. Untuk mengelola dan memahami data-data tersebut, diperlukan teknologi yang tepat. Salah satu teknologi yang muncul sebagai solusi adalah Big Data.

Pendahuluan

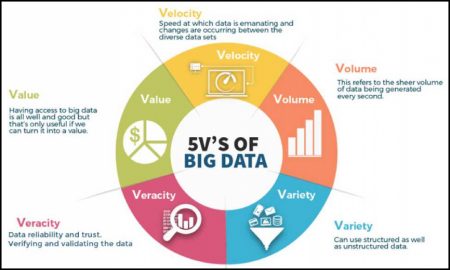

Big Data adalah istilah yang digunakan untuk menggambarkan volume besar, kecepatan tinggi, dan keragaman data yang tidak dapat diolah dengan menggunakan metode tradisional. Teknologi Big Data memungkinkan organisasi untuk mengumpulkan, menyimpan, mengolah, dan menganalisis data dalam skala besar secara efisien.

Dalam eksplorasi teknologi Big Data, terdapat dua kelompok utama yang dapat dibedakan: 1) Ingestion dan Storage (pengumpulan dan penyimpanan) data serta 2) Processing and Analytics (pengolahan dan analisis) data.

1. Ingestion and Storage (Pengumpulan dan Penyimpanan Data)

Kelompok pertama dalam teknologi Big Data adalah pengumpulan dan penyimpanan data. Dalam tahap ini, tujuan utama adalah mendapatkan sumber data dengan cepat serta menyimpannya secara efisien agar dapat diakses ketika diperlukan.

– Sistem Distributed File System (DFS)

Sistem DFS merupakan bagian yang krusial dalam Big Data karena memungkinkan penyimpanan data secara terdistribusi pada beberapa server fisik. Contoh DFS yang populer adalah Hadoop Distributed File System (HDFS). Kelebihan dari DFS adalah kemampuan untuk menyimpan data dalam ukuran yang sangat besar dan memiliki kemampuan replikasi data sehingga dapat memberikan redundansi dan keamanan.

– Apache Kafka

Apache Kafka adalah platform streaming data yang memungkinkan pengumpulan, pengiriman, dan penerimaan pesan secara real-time. Dengan menggunakan Kafka, data bisa di-stream secara cepat dan efisien dari satu aplikasi ke aplikasi lainnya.

2. Processing and Analytics (Pengolahan dan Analisis Data)

Kelompok kedua dalam teknologi Big Data adalah pengolahan dan analisis data. Setelah data dikumpulkan dan disimpan, langkah selanjutnya adalah menjalankan proses pengolahan dan analisis untuk mendapatkan informasi berharga.

– Apache Spark

Apache Spark merupakan framework pemrosesan data paralleldalam skala besar yang dirancang untuk mengolah data dengan cepat. Dengan menggunakan Spark, kita dapat melakukan analisis kompleks seperti machine learning, graph processing, serta streaming analytics dengan lebih efisien.

– Hadoop MapReduce

Hadoop MapReduce juga merupakan framework penting dalam Big Data yang digunakan untuk memproses sejumlah besar data secara terdistribusi. Metode ini membagi tugas-tugas komputasi ke beberapa node komputer agar proses menjadi lebih cepat.

Rangkuman

Big Data adalah solusi dalam mengelola dan memahami data dalam skala besar. Dalam eksplorasi teknologi Big Data, terdapat dua kelompok utama yaitu pengumpulan dan penyimpanan data serta pengolahan dan analisis data. Kelompok pertama melibatkan teknologi seperti Distributed File System dan Apache Kafka, sedangkan kelompok kedua menggunakan Apache Spark dan Hadoop MapReduce.

Dengan perkembangan teknologi Big Data ini, banyak organisasi berhasil memanfaatkan potensi data yang ada untuk meningkatkan efisiensi bisnis, membuat keputusan yang lebih baik, serta mengidentifikasi tren pasar. Semua ini mungkin dilakukan melalui kemampuan yang diberikan oleh teknologi Big Data dalam mengolah dan menganalisis data secara efisien.